BigLake: waarom en hoe te gebruiken?

Les organisations voient leurs données se développer à un rythme accéléré. En hoewel de medewerkers oplossingen ontwikkelen met de beste hulpmiddelen, bevinden de gegevens zich vaak op verschillende locaties, in verschillende formaten en zelfs op verschillende cloudplatforms. Deze steeds verder verspreide gegevens leiden tot silo's, en deze silo's van gegevens brengen hun eigen risico's en problemen met zich mee. Deze gegevens hebben echter een grote analytische waarde die kan inspelen op nieuwe gevallen van klantgebruik die steeds veeleisender worden.

Om te evolueren in een digitale wereld die volop in ontwikkeling is, moeten bedrijven de silo's van gegevens verwijderen en nieuwe gevallen van analytisch gebruik mogelijk maken, ongeacht de plaats waar de gegevens worden opgeslagen of hun formaat.

Om dit probleem tussen de gegevens en de toegevoegde waarde op te lossen, heeft Google een nieuwe functie geïntroduceerd: BigLake. BigLake is gebaseerd op de jaren van innovatie van BigQuery, het is een opslagmedium dat data lakes en datawarehouses verenigt, en tegelijkertijd een toegangscontrole op hoge granulariteit, een verbeterde prestatie bij multi-cloud opslag en de verwerking van oude bestandsformaten biedt.

Architectuur - Wat is BigLake?

En créant des tables BigLake dans BigQuery ou en utilisant le connecteur BigLake sur des moteurs open-source, tels qu'Apache Spark, vous pouvez étendre votre accès aux données dans Amazon S3, Azure Data Lake Storageen bien sûr Google cloudopslag.

Les données sont accessibles via les formats de données ouverts pris en charge: Avro, CSV, JSON, ORC en Parquet. En sindsdien, Google Cloud Next 2022, ook: Apache ijsberg, Deltameer en Apache Hudi.

BigLake biedt de controle over de toegang tot beveiliging op hoog granulaatniveau van BigQuery op het niveau van de tabel, de ligne of de colonne. Dankzij BigQuery Omni wordt deze veiligheidspolitiek op dezelfde manier toegepast op andere cloudplaten. Het maakt interoperabiliteit tussen datawarehouses en data lakes mogelijk en geeft een unieke kopie van de gegevens.

Comme les tables BigLake sont un type de tables BigQuery, elles peuvent également être découvertes de manière centralisée dans le catalogue de données et gérées à l'échelle à l'aide de Dataplex unifier la gouvernance et la gestion à l'échelle.

Démo - Hoe gebruik je BigLake?

In dit introductiefilmpje verkennen we de resultaten van een internationale triatlonwedstrijd. Het bestand bevat de volgende informatie over de deelnemers:

- ID

- Nom

- Betaalt

- Duur in minuten

Het bestand wordt opgeslagen in Google Cloud Storage. Voyons qui a le temps le plus rapide tout en préservant la vie privée des participants.

1. Maak eerst een verbinding

De eerste stap is het maken van een externe verbinding met onze gegevens. De verbinding tussen BigLake en Google Cloud Storage kan worden gemaakt op de pagina van de service BigQuery.

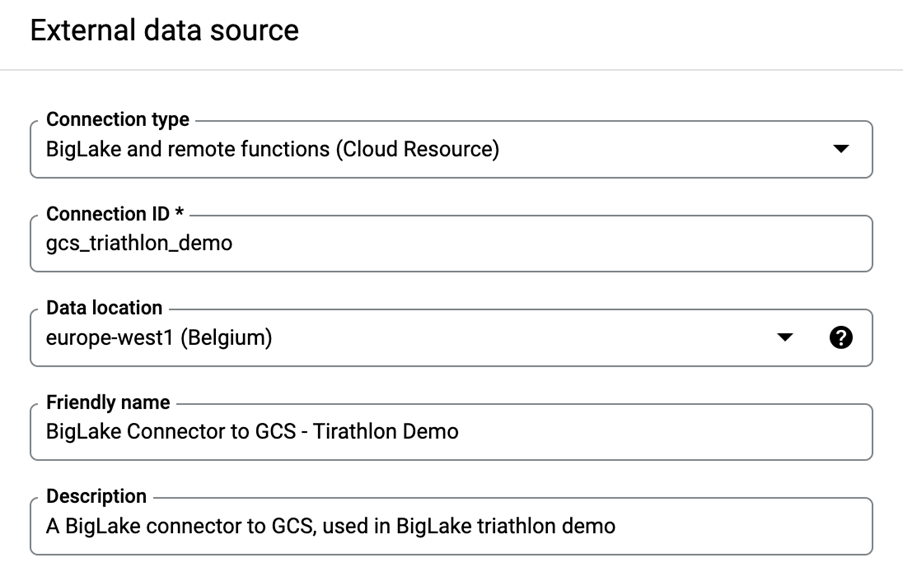

En haut à gauche, cliquez sur "+ ADD DATA". Une nouvelle fenêtre apparaîtra à droite, cliquez sur "Connexions aux sources de données externes", et remplissez les champs suivants:

- Type verbinding: kies "BigLake en functies op afstand".

- ID van de verbinding: "gcs_triathlon_demo". 3.

- Plaats van de gegevens : "europe-west1 (Belgique)".

- Nom et description de l'ami: facultatifs, mais utiles.

- Klik op "CREER UNE CONNEXION".

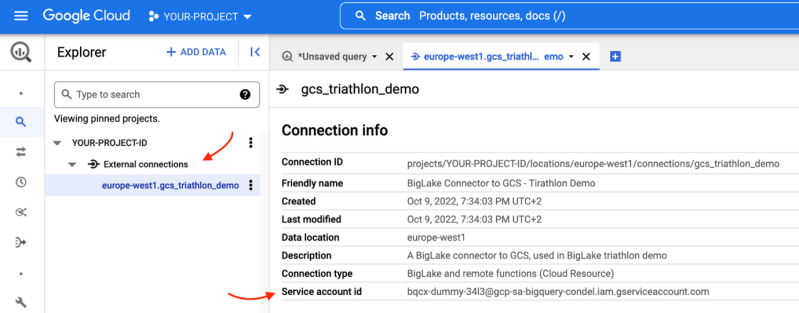

Als de verbinding is gemaakt, kunnen we deze visualiseren in het hoofdvenster, onder "Externe verbindingen":

Copions l'"ID du compte de service", car nous aurons besoin d'accorder la permission de lecture à ce compte de service sur le stockage d'objets.

2. Accorder au compte de service un accès en lecture

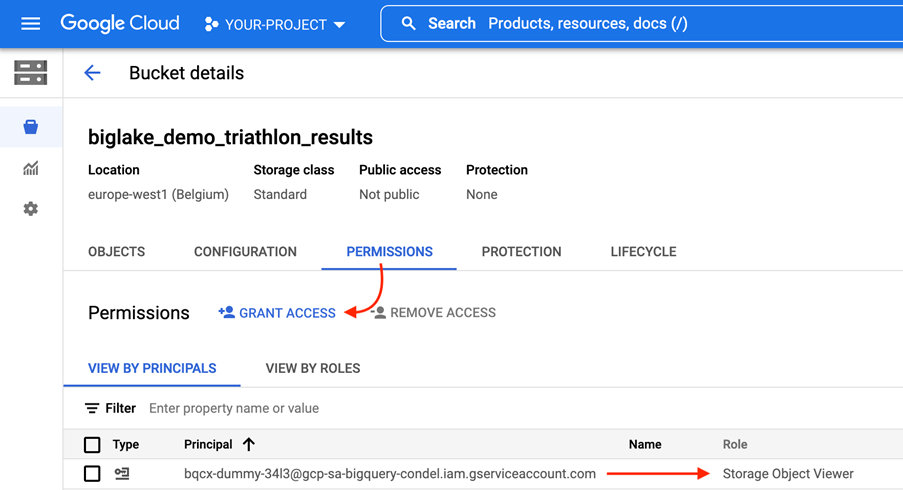

Volg het principe van de laagste rechten en accordeer geen globale rechten aan servicecomputers die dit niet nodig hebben. In ons geval geven we toestemming voor de visualisatie van objecten op het niveau van de emmer.

Navigeer naar de pagina Google cloud-opslag et accordez des autorisations de lecture au bucket contenant notre fichier de données.

Notre fichier est stocké dans le bucket appelé "biglake_demo_triathlon_results". We openen de emmer en navigeren naar het item "PERMISSIONS". Hier accorderen we "Storage Object Viewer" bij de service de connexions " bqcx-dummy-34l3@gcp-sa-bigquery-condel.iam.gserviceaccount.com "

3. Creëer de tafel BigLake

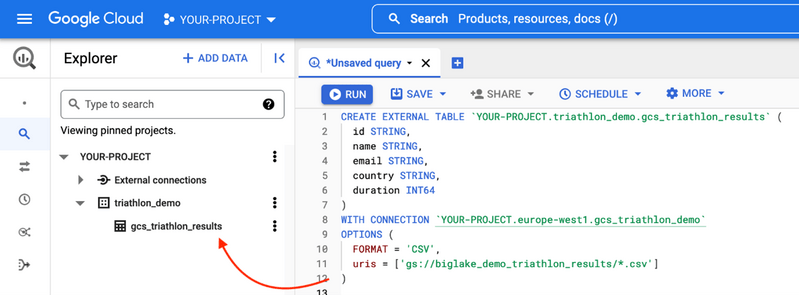

L'étape suivante consiste à créer notre table BigLake dans un ensemble de données appelé "triathlon_demo", il est situé dans la région "europe-west1", la même région où se trouvent nos données.

Au lieu de créer la table BigLake via l'interface utilisateur, nous allons changer les choses et la créer via SQL, en utilisant notre connexion BigLake :

CREATE EXTERNAL TABLE `YOUR-PROJECT.triathlon_demo.gcs_triathlon_results` (

id STRING,

nom STRING,

e-mail STRING,

betaalt STRING,

Duur INT64

)

- Onze BigLake-naar-GCS-connector

WITH CONNECTION `Uw-Project.europa-west1.gcs_triathlon_demo`

OPTIES (

FORMAAT = 'CSV',

uris = ['gs://biglake_demo_triathlon_results/*.csv']]

)

BigQuery laadt meerdere bronbestanden op in één tabel. Gebruik hiervoor de caractère générique ("\*").

Door het uitvoeren van het verzoek zoals hieronder wordt de tabel BigLake aangemaakt:

4. De persoonlijke informatie van de deelnemers beschermen

Via Dataplex kunnen we op transparante wijze een bestuur en een uniform beheer op het niveau van onze BigTable integreren. In deze video laten we zien hoe we de toegang tot kolommen kunnen herstellen door gebruik te maken van taxonomieën.

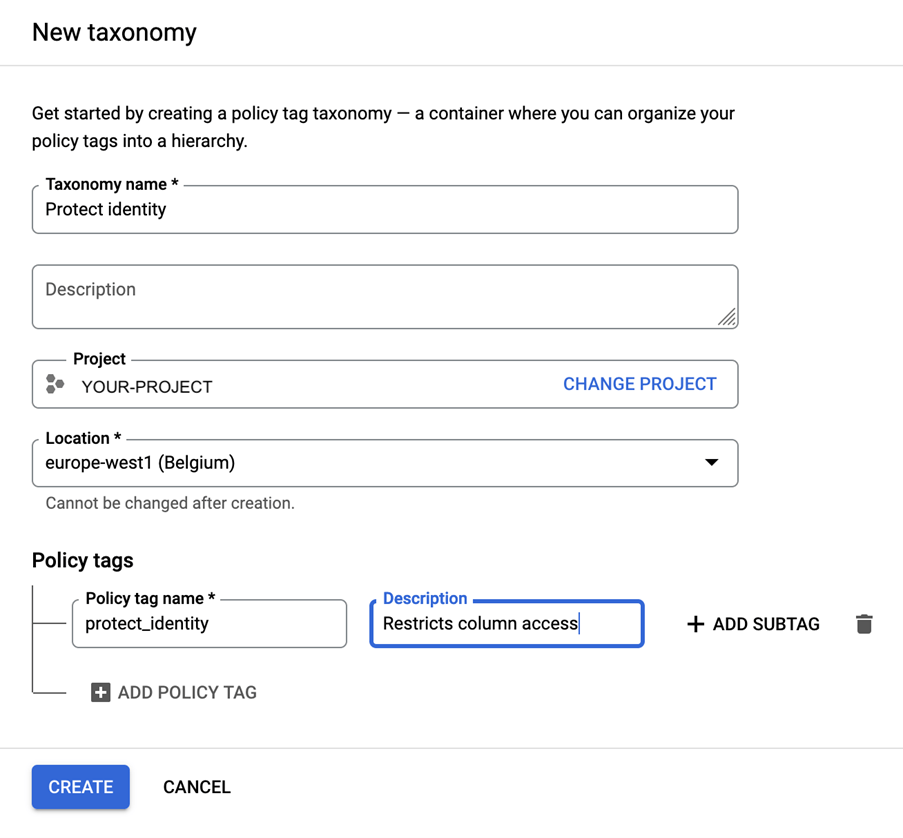

Voor het creëren van een tagbeleid moet eerst een taxonomie worden gedefinieerd, wat gebeurt via de pagina Taxonomie van Dataplex.

Klik op "CREER UNE NOUVELLE TAXONOMIE" en vul het formulier opnieuw in:

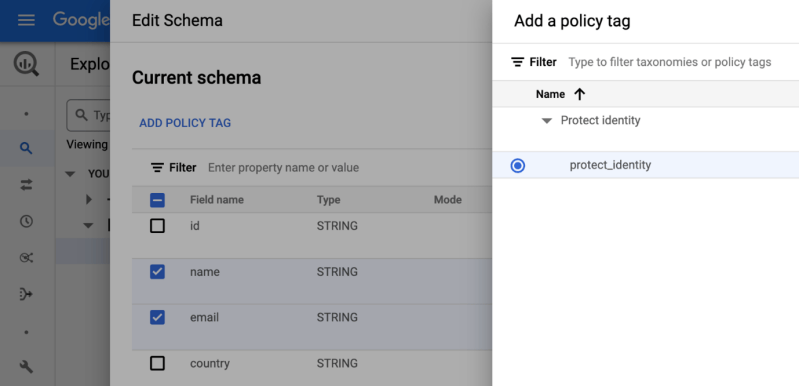

Eenmaal aangemaakt, past u het toe op de kolommen die we willen restreindre en die gevoelige informatie bevatten. Ga terug naar BigQuery en selecteer onze tabel BigLake. Klik op "EDIT SCHEMA", selecteer de kolommen "name" en "email" en klik op "ADD POLICY TAG". Selecteer het beleid en registreer de wijzigingen.

De darmen zijn nu beschermd. Test dit!

5. Resultaat: Wie heeft de beste tijd?

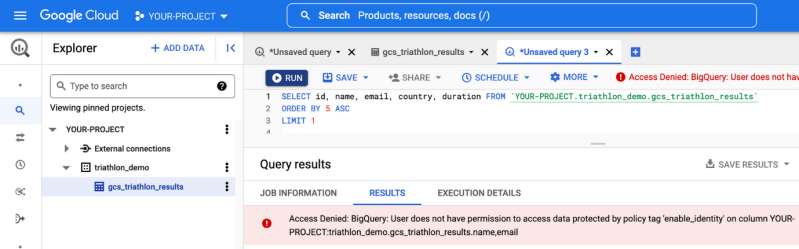

Quand tout est configuré, et que la politique du tag a été appliquée, découvrons qui a été le plus rapide.

Lorsque nous exécutons la requête, nous sommes accueillis par un message nous indiquant que nous n'avons pas la permission d'afficher les noms ou les e-mails des participants. Ons beleid werkt dus!

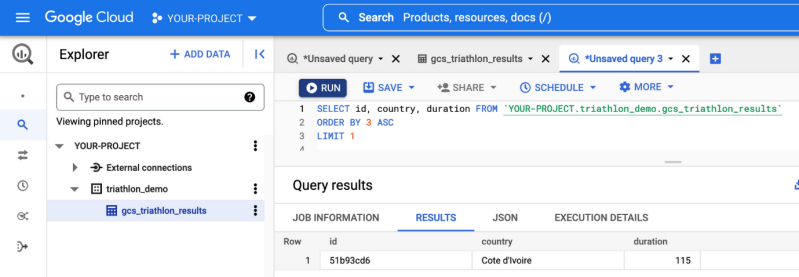

En exclude ces champs de la requête, nous pouvons enfin voir le résultat :

De deelnemer met de onbekende ID "51b93cd6" uit Ivoorkust heeft de hoogste tijd van 115 minuten.

6. Conclusie

BigLake vermindert de discrepantie tussen de toegevoegde waarde en de données en elimineert de silo's van données op cloudplatforms en neemt de controle over de toegang tot hoge granulariteit en het beheer van meervoudige gedistribueerde données op zich. Het is een tool die uitstekend past in een organisatie met meerdere clouds.

Belangrijkste opleidingen van BigLake

- Gestion d'une copie unique des données avec un ensemble de fonctionnalités uniformes dans les data lakes et les data warehouses.

- Contrôle d'accès à haute granularité sur la plateforme multi-cloud.

- Integratie met open-source logiciels en gebruik van externe gegevensformaten.

- Voordelen op niveau van BigQuery

Meer weten?

Neem contact met ons op!