Inleiding

Na de aankondiging van Microsoft Microsoft Fabric lors de la conférence Build qui débutera le 23 mai 2023, Microsoft Fabric a été lancé en avant-première publique. Het beschikt over een groot aantal functies om uw donatiedomein te uniformeren en de manier te veranderen waarop het geheel van uw team de donaties verzamelt. Le moteur serverless amélioré is volledig gebaseerd op delta lake en biedt een aantal nieuwe mogelijkheden in de wereld van de donaties.

Klik hier om uw database met Microsoft Fabric KQL (Kusto Query Language) aan te sluiten op de streaming Azure Event Hubs. U kunt deze functies combineren om uw gegevens te verspreiden naar een KQL-magazijn in Microsoft Fabric. Dit is niet de enige bron of bestemming, zoals we verderop in dit artikel doen.

Composants dont vous aurez besoin:

- Abonnement Azuur

- Gebeurtenishub-naamruimte + Gebeurtenishub

- Microsoft Fabric compte (versie d'essai)

- Streaming dataset (als u een geïntegreerde dataset gebruikt, kunt u deze stap versnellen)

Voor de nomenruimte van de hub d'events kunt u het basisniveau voor tarifering gebruiken, maar u loopt het risico dat u de limiet van de groep van gebruikers niet haalt (1 groep van gebruikers mogelijk). U ziet geen informatie meer over de groep gebruikers $Default in het portail zodra u uw Microsoft Fabric KQL DB met de groep gebruikers hebt verbonden.

U kunt dit nog wijzigen nadat u de ruimte met namen van de hub voor evenementen hebt gecreëerd.

Analyse in real time

Étape 1 - Plaats

Gebruik uw favoriete navigator om verbinding te maken met https://app.fabric.microsoft.com/.

We gebruiken voornamelijk het onglet "Real-Time Analytics" (de laatste). Sélectionnez-le pour accéder à la page d'accueil de RTA.

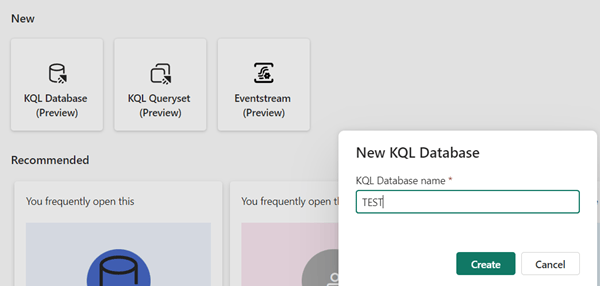

Vanaf hier kunnen we eenvoudig een nieuwe database met KQL-documenten maken door de knop KQL Database (Preview) vooraan te selecteren en een significante naam in te voeren. (TEST is veelzeggend, nietwaar?).

Daarna moet u uw database met gegevens bekijken die is geopend in het onglet Real-Time Analytics.

Als je geen zicht meer hebt op de plaats van de database KQL die je gaat maken, is het voldoende om terug te gaan naar de ingang van je werkruimte en een aantal filters toe te passen. Bijvoorbeeld op de naam of op de gegevensbank KQL (of beide).

Deel 2 - Begin met het invoeren van gegevens

Het is nu tijd om te beginnen met het invoeren van gegevens in de database van KQL.

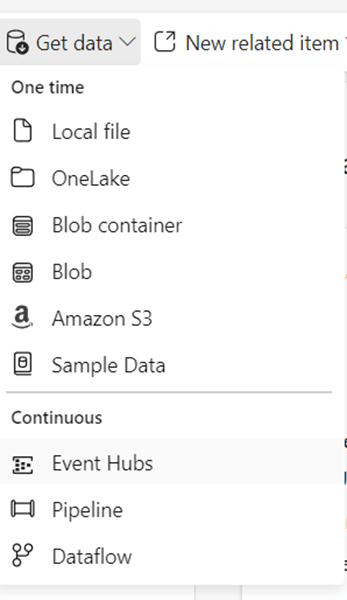

We kunnen kiezen tussen get data -> Event Hubs (zie afbeelding rechts) of...

... maak een tableau!

Daarnaast is er een belangrijke verbinding met onze Event Hubs + Event Hub-ruimte die we moeten opzetten.

Deel 3 - Verbinding met de cloud

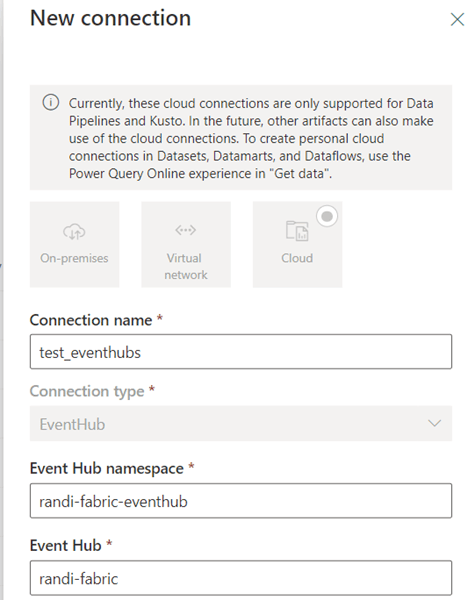

Selecteer in het vak Source de données Event Hubs de optie Créer une nouvelle connexion cloud.

Cela ouvrira un autre onglet du navigateur (qui se fermera automatiquement, voir mon article de blog précédent "5 conseils pour démarrer avec Microsoft Fabric" sur la façon de gérer les connexions sans que la fermeture automatique ne se produise.

La première partie est très simple, vous choisissez un nom de connection, en espérant qu'il soit plus significatif que le mien. Vervolgens voert u de Azure Event Hub-namespace + Azure Event Hub in die hoort bij de naamruimte waar u verbinding mee maakt.

Étape 4 - Authentificatie

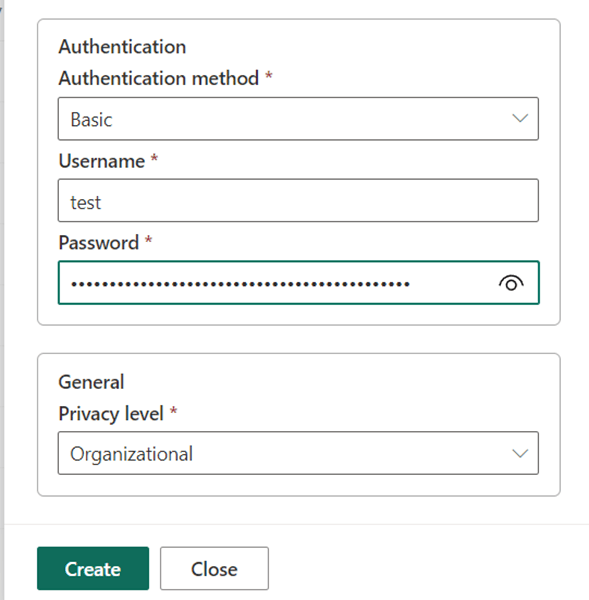

Voor de basisauthenticatie (momenteel de enige mogelijkheid) moet je een politique d'accès partagé invoeren. Hiervoor gebruikt u de naam van de politiek en de waarde van de koppeling (primair of secondair) die hierbij hoort. Le nom de la politique = nom d'utilisateur, la valeur de la clé = mot de passe.

U kunt gebruik maken van de policy par défaut de l'espace de noms, maar het is raadzaam om er een te creëren voor de hub waar u verbinding mee maakt. Vous n'avez également besoin que du droit d'écoute sur ce hub d'événements. We hopen in de toekomst meer authenticatiemethoden te hebben, maar dit is de minst geprivilegieerde benadering.

Deel 5 - Een gegevensverzameling voorbereiden

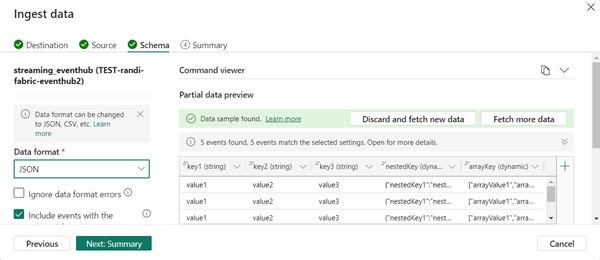

Après avoir effectué cette opération, assurez-vous d'abord que vous disposez d'un échantillon de données pour ce groupe de consommateurs avant de passer au schéma. Dans l'onglet Schéma, fabric essaiera immédiatement d'utiliser les données du concentrateur d'événements pour créer un schéma.

Als je geen voorgeprogrammeerde gegevens hebt, kun je de functie voor visualisatie gebruiken om gegevens te genereren in de hub van gebeurtenissen zelf.

Étape 6 - Afronding

Ces données étant prêtes, nous pouvons aller dans schema et voir notre schéma en cours de construction pour notre hub d'événements:

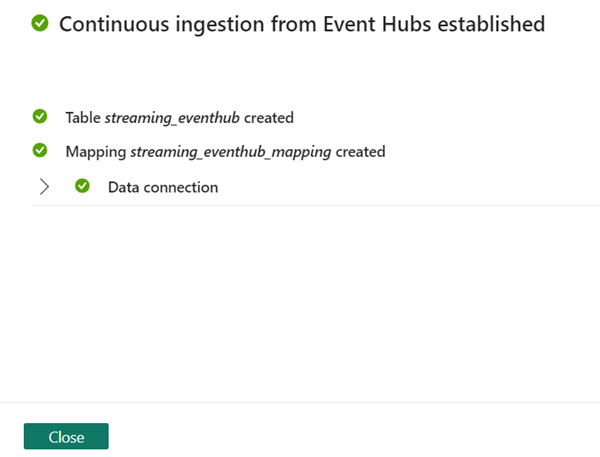

Zorg ervoor dat je hier het juiste formaat selecteert. Tijdens de test was het formaat bij voorbaat TXT, terwijl het ging om données JSON. Allez dans Résumé et vous devriez voir des coches vertes partout.

Après cela, vous avez terminé! Vous devriez voir vos données Event Hub se remplir dans votre base de données KQL, vous pouvez facilement interroger la table en sélectionnant "..." -> "Query Table" -> "Show Any 100 Records" ou "Records ingested in the last 24 hours".

Conclusie

Hoewel deze configuratie werkt voor het streamen van gegevens van je hub van evenementen naar een database met gegevens van KQL, is er weinig zichtbaarheid bij de bron en de bestemming.

Een ander probleem is dat er geen eenvoudigere manier is om bronnen of meerdere objecten te configureren. Zoals we in mijn volgende blogartikel zullen lezen, zijn er ook meer mogelijkheden om de données van de Event Hubs in te voeren in bijvoorbeeld een Lakehouse. Om dit alles en nog meer te kunnen doen, ga naar mijn volgende blogartikel op : "Utiliser Eventstreams pour alimenter les données de votre hub d'événements vers la base de données KQL de Microsoft Fabric ou Lakehouse".